בחודשים האחרונים, קהילת הבינה המלאכותית נתונה לדיון סוער שהתעורר בעקבות שני מאמרי מחקר משפיעים שפורסמו על ידי אפל . הראשון, "GSM-Symbolic" (אוקטובר 2024), והשני, "The Illusion of Thinking" (יוני 2025), הטילו ספק ביכולות החשיבה לכאורה של מודלים של שפה גדולה, מה שעורר תגובות מעורבות ברחבי התחום.

כפי שדנו במאמר הקודם שלנו "אשליית הקידמה: סימולציה של בינה כללית מלאכותית מבלי להשיגה", סוגיית החשיבה המלאכותית נוגעת ללב ליבה של מה שאנו מחשיבים כאינטליגנציה במכונות.

חוקרי אפל ערכו ניתוח שיטתי של מודלים של חשיבה גדולה (LRM) - מודלים המייצרים מסלולי חשיבה מפורטים לפני מתן תשובה. התוצאות היו מפתיעות, ולרבים, מדאיגות.

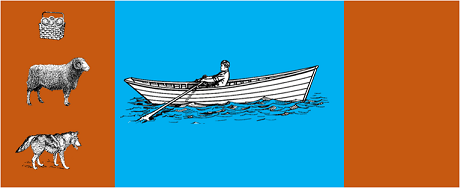

המחקר העביר את המודלים המתקדמים ביותר לחידות אלגוריתמיות קלאסיות כגון:

התוצאות הראו שאפילו שינויים קטנים בניסוח הבעיה הובילו לשינויים משמעותיים בביצועים , דבר המצביע על חולשה מדאיגה בנימוק. כפי שדווח בסיקור של AppleInsider , "ביצועי כל המודלים ירדו כאשר רק הערכים המספריים בשאלות benchmark GSM-Symbolic שונו".

תגובת קהילת הבינה המלאכותית הייתה מהירה. אלכס לוסן מ-Open Philanthropy, בשיתוף פעולה עם קלוד אופוס מ-Anthropic, פרסמו תגובה מפורטת תחת הכותרת "האשליה של אשליית החשיבה", ובה ערערו על המתודולוגיות והמסקנות של המחקר של אפל.

כאשר לוסן חזר על הבדיקות עם מתודולוגיות חלופיות - ביקש מהמודלים לייצר פונקציות רקורסיביות במקום לפרט את כל המהלכים - התוצאות היו שונות באופן דרמטי. מודלים כמו קלוד, ג'מיני ו-GPT פתרו בהצלחה בעיות של מגדל האנוי עם 15 דיסקים, הרבה מעבר למורכבות שבה אפל דיווחה על אפס הצלחות.

גארי מרקוס , מבקר ותיק של יכולות החשיבה של סטודנטים למשפטים, שיבח את ממצאי אפל כאישור לתזה בת 20 השנים שלו. לדברי מרקוס, סטודנטים למשפטים ממשיכים להיאבק ב"הסטה חלוקתית" - היכולת להכליל מעבר לנתוני אימון - תוך שהם נשארים "פותרים טובים של בעיות פתורות".

הדיון גלש גם לקהילות ייעודיות כמו LocalLlama ב-Reddit , שם מפתחים וחוקרים דנים בהשלכות המעשיות של מודלים בקוד פתוח ויישום מקומי.

ויכוח זה אינו אקדמי גרידא. יש לו השלכות ישירות על:

כפי שמודגש במספר תובנות טכניות , הצורך בגישות היברידיות המשלבות:

דוגמה טריוויאלית : עוזר בינה מלאכותית שעוזר בחשבונאות. מודל השפה מבין כששואלים "כמה הוצאתי על נסיעות החודש?" ומחלץ את הפרמטרים הרלוונטיים (קטגוריה: נסיעות, תקופה: החודש). אבל שאילתת ה-SQL שמבצעת שאילתה במסד הנתונים, מחשבת את הסכום ובודקת אילוצי מס? זה נעשה על ידי קוד דטרמיניסטי, לא על ידי מודל עצבי.

לא נעלם מעיני הצופים שהמאמר של אפל פורסם זמן קצר לפני WWDC, מה שעורר שאלות לגבי המניעים האסטרטגיים שלו. כפי שמציין ניתוח של 9to5Mac , "התזמון של המאמר של אפל - ממש לפני WWDC - עורר כמה גבות. האם זו הייתה אבן דרך מחקרית, או מהלך אסטרטגי למיצוב מחדש של אפל בנוף הבינה המלאכותית הרחב יותר?"

הדיון שעוררו מאמרי אפל מזכיר לנו שאנחנו עדיין בשלבים המוקדמים של הבנת הבינה המלאכותית. כפי שהודגש במאמר הקודם שלנו, ההבחנה בין סימולציה לחשיבה אותנטית נותרה אחד האתגרים המורכבים ביותר של זמננו.

הלקח האמיתי אינו האם תואר שני במשפטים (LLMs) יכול "להסיק היגיון" במובן האנושי של המילה, אלא כיצד נוכל לבנות מערכות שממנפות את נקודות החוזק שלהן תוך פיצוי על מגבלותיהן. בעולם שבו בינה מלאכותית כבר משנה תעשיות שלמות, השאלה אינה עוד האם כלים אלה "אינטליגנטיים", אלא כיצד להשתמש בהם ביעילות ובאחריות.

עתיד הבינה המלאכותית הארגונית כנראה לא יהיה טמון בגישה מהפכנית אחת, אלא בתזמור חכם של מספר טכנולוגיות משלימות. ובתרחיש זה, היכולת להעריך באופן ביקורתי וכנה את יכולות הכלים שלנו הופכת ליתרון תחרותי בפני עצמו.

התפתחויות אחרונות (ינואר 2026)

OpenAI משחררת את o3 ו-o4-mini : ב-16 באפריל 2025, OpenAI פרסמה בפומבי את o3 ו-o4-mini, מודלי החשיבה המתקדמים ביותר בסדרת o-. מודלים אלה יכולים כעת להשתמש בכלים באופן מבוסס סוכן, המשלב חיפוש באינטרנט, ניתוח קבצים, חשיבה חזותית ויצירת תמונות. o3 קבע שיאים חדשים במבחנים כמו Codeforces, SWE-bench ו-MMMU, בעוד ש-o4-mini ממטב את הביצועים והעלות עבור משימות חשיבה בנפח גבוה. המודלים מדגימים יכולות "חשיבה תמונה", תוך שינוי חזותי של תוכן לניתוח מעמיק יותר.

DeepSeek-R1 מטלטל את תעשיית הבינה המלאכותית : בינואר 2025, DeepSeek הוציאה את R1, מודל חשיבה בקוד פתוח שהשיג ביצועים דומים ל-OpenAI O1 בעלות אימון של 6 מיליון דולר בלבד (לעומת מאות מיליונים עבור מודלים מערביים). DeepSeek-R1 מדגים שניתן לשפר מיומנויות חשיבה באמצעות למידה מבוססת חיזוקים טהורה, ללא צורך בהוכחות אנושיות מבוארות. המודל הפך לאפליקציה החינמית מספר 1 ב-App Store וב-Google Play בעשרות מדינות. בינואר 2026, DeepSeek פרסמה מאמר מורחב בן 60 עמודים שחשף את סודות האימון והודה בגלוי כי טכניקות כמו Monte Carlo Tree Search (MCTS) לא עבדו עבור חשיבה כללית.

אנתרופיק מעדכנת את "החוקה" של קלוד : ב-22 בינואר 2026, אנתרופיק פרסמה חוקה חדשה בת 23,000 מילים עבור קלוד, שעוברת מגישה מבוססת כללים לגישה המבוססת על הבנה של עקרונות אתיים. המסמך הופך למסגרת הראשונה של חברת בינה מלאכותית גדולה שמכירה רשמית באפשרות של תודעה או מעמד מוסרי של בינה מלאכותית, וקובעת כי אנתרופיק דואגת ל"רווחתו הנפשית, תחושת העצמי ורווחתו" של קלוד.

הוויכוח מתעצם : מחקר משנת 2025 שחזר ועידן את מדדי הביצועים של אפל, ואישר כי מערכות LRM עדיין מציגות מגבלות קוגניטיביות כאשר המורכבות עולה במידה מתונה (כ-8 דיסקים במגדל האנוי). החוקרים הדגימו שזה לא רק נובע מאילוצי פלט, אלא גם ממגבלות קוגניטיביות בעולם האמיתי, מה שמדגיש שהוויכוח רחוק מלהסתיים.

לקבלת תובנות לגבי אסטרטגיית הבינה המלאכותית של הארגון שלכם ויישום פתרונות חזקים, צוות המומחים שלנו זמין לייעוץ אישי.